媒体小编们熬夜赶稿时最怕啥?

AI突然编个假新闻让你背锅!

2025年7月10日,新京报发布最新AI大模型测评报告,抽了11款国产模型五大能力,结果翻译和信息搜索刚及格,但96%的媒体人每周都会撞上AI瞎编乱造,虚假信息成了行业集体噩梦。

这报告直接捅破窗户纸:AI工具越用越顺手,但媒体把关压力反而更大了。

数据看着挺唬人。

八成记者承认AI确实能提速,但幻觉问题比去年更严重了。

有小编连遇三天AI造假标题,还有模型把退休高管编成现任领导。

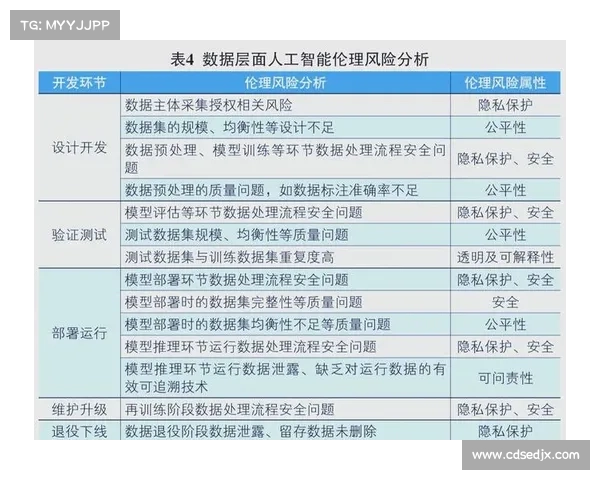

更扎心的是伦理测试,8款模型参加新设的价值观考核,遇到争议性社会事件时,过半模型要么和稀泥要么站错队,性别平等类问题翻车最多。

说白了,模型练的都是网上陈年数据,带偏见的信息喂多了自然长歪。

多模态能力更是拖后腿。

现在视频新闻爆发式增长,可多数模型连图文对照都整不明白。

pc28预测测试员上传车祸现场图配文字"司机轻伤",结果五个模型里有三个生成"重大伤亡事故"。至于视频自动剪辑?基本处在把发布会剪成恐怖片的水准。有技术宅吐槽这像让小学生做高考试卷——工具都没认全呢。

长文本处理进步明显却不够用。去年财报分析全军覆没,今年总算能上传百页文档了,可关键数据抓取照样翻车。某券商报告里的盈利预测被AI总结成亏损,吓得编辑连夜人工复核。更迷的是"大海捞针"测试,故意在300页文档里藏句关键结论,结果十一个模型集体眼瞎。业内人士苦笑:现在看AI分析报告,得自带人工纠错器。

隐私焦虑也在暴增。95.6%的受访者担心数据泄露,比去年飙了9个百分点。有记者用AI整理采访录音,第二天居然收到诈骗电话精准报出当事人姓名。某媒体因此立了新规矩:涉及案件的敏感内容宁可手打三小时,绝不喂给AI一个字。

说到底,工具终究是工具。报告里那个坚持人工核稿十五年的主编说得好:以前怕记者写错字,现在怕AI编故事。技术跑得再快,编辑部里那根弦松不得。这测评给所有媒体提了个醒:别光顾着省时省力,内容安全的成本其实更高了。

看麻了 小编人均AI驯兽师是吧

翻译查资料还行 写稿就算了吧

上次用某模型写两会解读 给我编出个新部门

伦理测试居然不及格 某些模型三观比营销号还歪

长文本进步有屁用 关键数据照样抓瞎

现在看到"AI生成"标签就划走

建议给大模型发记者证 出事直接吊销

工具出问题不可怕 可怕的是依赖工具的人不动脑子